วันนี้แอปเปิ้ล (Apple) ได้ประกาศเตรียมเพิ่มฟีเจอร์คุ้มครองความปลอดภัยให้กับเด็กที่มีอายุต่ำกว่า 18 ปี จากการเข้าถึงวัตถุหรือสิ่งแสดงการล่วงละเมิดทางเพศเด็ก (Child Sexual Abuse Material : CSAM)

สำหรับฟีเจอร์คุ้มครองเด็กนี้ แอปเปิ้ลจะเพิ่มความสามารถใน 3 รูปแบบด้วยกัน ในแอปการสื่อสารอย่างแอปข้อความ ระบบการตรวจจับสื่อลามกอนาจารเด็ก (CSAM) และใน Siri และการค้นหา

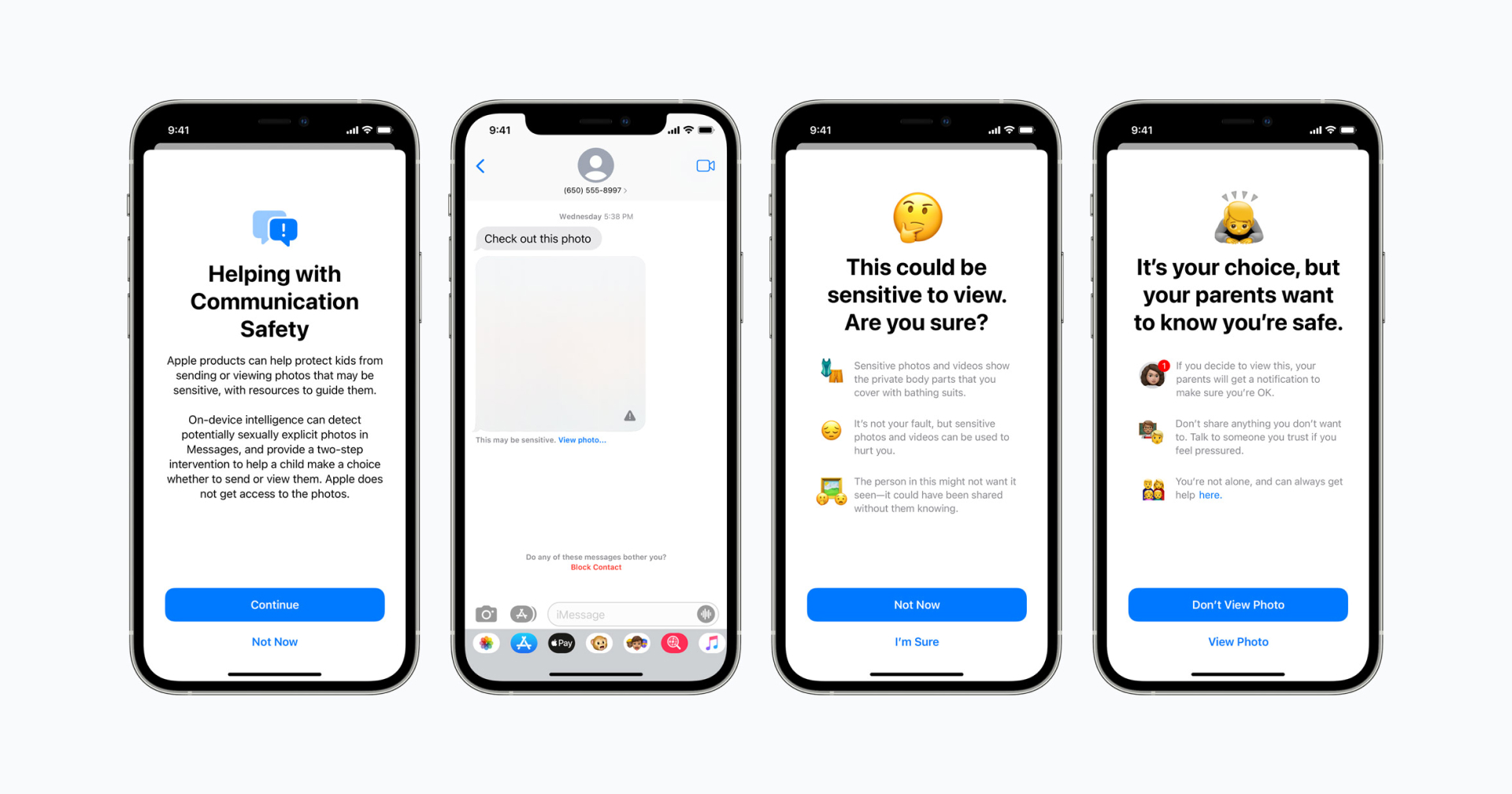

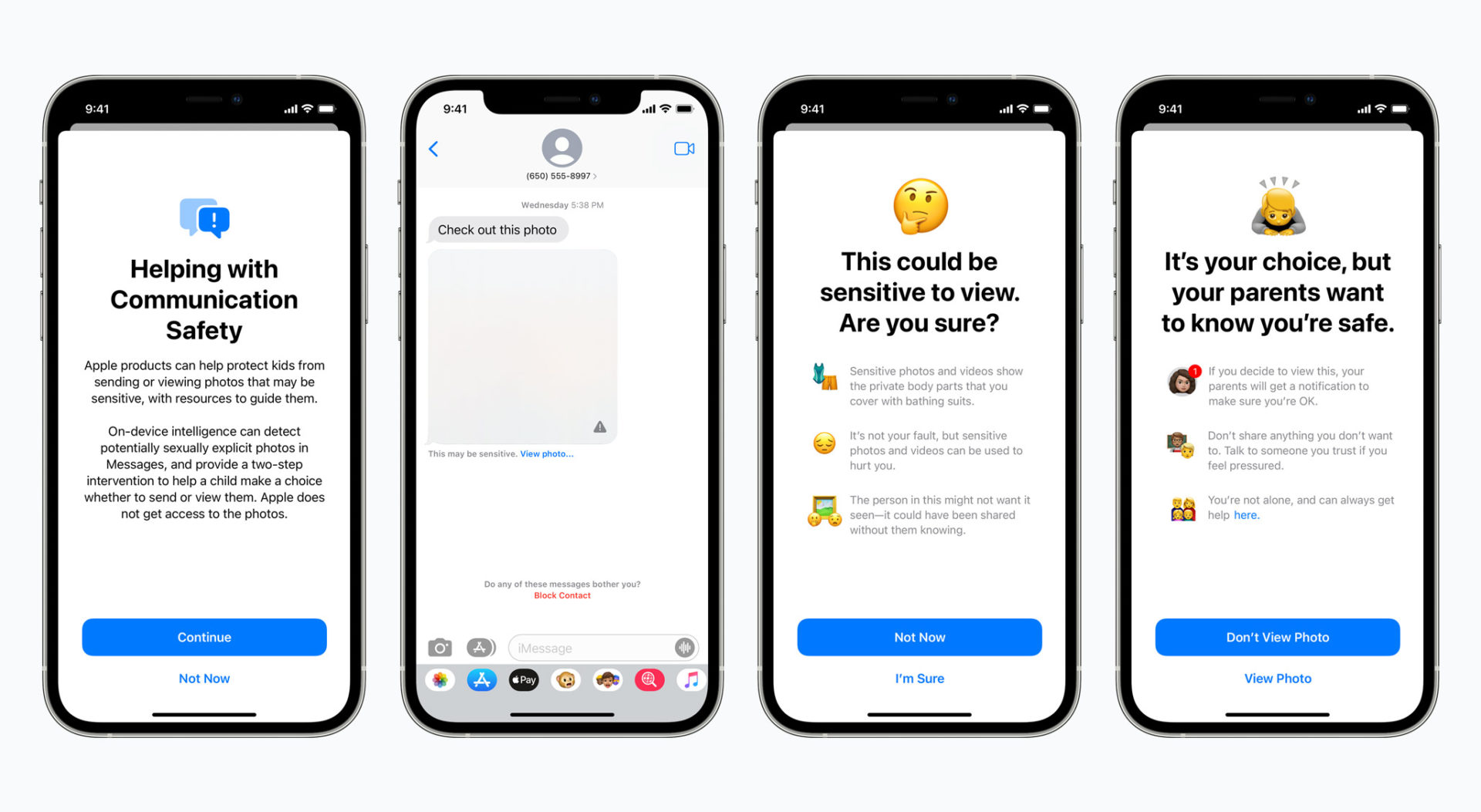

ในแอปข้อความ (Messages) จะมีการเพิ่มเครื่องมือที่จะคอยเตือน เซ็นเซอร์ หรือเบลอรูปภาพ หากมีผู้ส่งรูปภาพอนาจารให้เด็กที่มีอายุต่ำกว่า 18 ปี หรือเป็นคนส่งรูปเอง พร้อมกับแจ้งผู้ปกครองให้ทราบด้วย แอปข้อความจะใช้ Machine Learning ในตัวเครื่องเพื่อวิเคราะห์และประมวลผลว่าภาพดังกล่าวเป็นภาพลามกอนาจารหรือไม่ โดยฟีเจอร์นี้จะสามารถใช้ได้เฉพาะบนบัญชี Apple หรือ iCloud ที่มีการตั้งค่าครอบครัวไว้แล้วเท่านั้น

ระบบการตรวจจับสื่อลามกอนาจารเด็ก (CSAM) จะใช้เทคโนโลยีกันกับฟีเจอร์ในแอปข้อความในการตรวจจับ ก่อนภาพจะถูกอัปโหลดขึ้นไปบน iCloud Photos โดยระบบจะทำการเปรียบเทียบกับฐานข้อมูลสื่อลามกอนาจรจากศูนย์เพื่อเด็กหายและถูกฉวยผลประโยชน์แห่งชาติของสหรัฐอเมริกา (U.S. National Center for Missing and Exploited Children : NCMEC) และองค์กรคุ้มครองเด็กอื่น ๆ

สุดท้าย Siri และการค้นหา จะเข้ามาเตือนผู้ใช้หากผู้ใช้กำลังค้นหาข้อมูลที่เกี่ยวกับการละเมิดอยู่ พร้อมให้คำแนะนำ

ทั้งนี้ฟีเจอร์ทั้งหมดนี้จะสามารถใช้ได้ใน iOS 15, iPadOS 15, watchOS 8, และ macOS Monterey ที่จะเปิดตัวในช่วงปลายปีนี้ และแอปเปิ้ลได้ระบุว่าจะยังสามารถใช้ได้ในสหรัฐฯ เท่านั้น

อ้างอิง : Apple