เป็นเรื่องที่น่าทึ่งที่ตอนนี้ระบบคอมพิวเตอร์สามารถจะบรรยายภาพๆนึงจากสิ่งที่อยู่ในรูปได้แล้ว บรรยายออกมาได้ตรงหรือไม่ มาดูกันครับ

ตอนนี้ เทคโนโลยีมันเริ่มก้าวหน้าไปมากกว่าเดิมแล้ว ซึ่งล่าสุด มีซอฟต์แวร์ที่สามารถระบุ และ บรรยายรูปภาพได้จากสิ่งที่เห็นจากในรูปๆนั้น

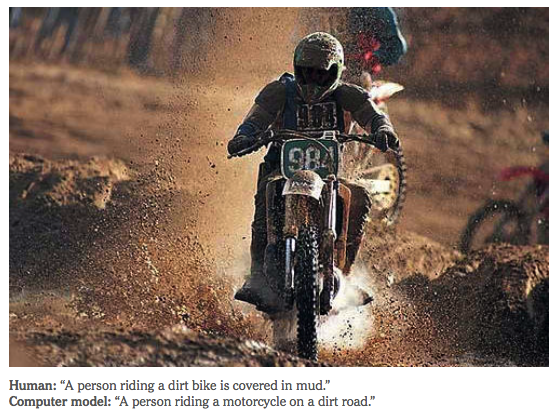

สิ่งที่เห็นก็คือ คนขี่มอเตอร์ไซค์ และ มอเตอร์ไซค์เลอะไปด้วยดินและโคลน

- คำบรรยายรูปที่ทำโดยมนุษย์ ได้แก่ “A person riding a dirt bike is covered in mud.”

- คำบรรยายที่คอมพิวเตอร์ได้ตั้งขึ้นมาให้ก็คือ “A person riding a motorcycle on a dirt road.”

ซึ่งก็ถือว่าคอมพิวเตอร์บรรยายออกมาได้ใกล้เคียงกับที่มนุษย์คิด

ระบบคอมพิวเตอร์นี้เป็นการทำงานร่วมกันของ 2 องค์กร ได้แก่ นักวิจัยของ Google และ นักวิจัยของมหาวิทยาลัยสแตนฟอร์ด

ระบบคอมพิวเตอร์รวมเอาสองระบบเข้าด้วยกันได้แก่

- image recognition หรือระบบการจดจำรูปภาพ เมื่อเห็นอะไรในรูปก็สามารถจะบอกได้ว่ามันคืออะไรเช่นว่า ในรูปมีคน มีม้า มีจักรยาน

- natural language processing หรือระบบประมาลผลภาษา

ซึ่งเมื่อระบบ 2 ระบบนี้ทำงานด้วยกันแล้ว ระบบแรกเมื่อเห็นภาพ ก็จะตีค่าของภาพว่ามันคืออะไรด้วยระบบจดจำภาพ ต่อจากนั้นระบบประมวลผลคำจะทำงานต่อ เพื่อจะตีค่าภาพที่จำได้ให้เป็นคำ พร้อมทั้งประมวลผลออกมาโดยบรรยายภาพโดยรวม

ซึ่งจากการทดสอบให้ทำคำบรรยายภาพ ผลออกมาก็น่าทึ่งกว่าที่คิดไว้ เพราะ คาดไว้แค่ระบบจะบรรยายแห้งๆ แค่มีคนขี่มอร์เตอร์ไซด์ แล้วก็จบ แต่ระบบกลับบรรยายออกมาได้ใกล้เคียงกับสิ่งที่มนุษย์บรรยาย

แต่อย่างไรก็ตาม เทคโนโลยีนี้ก็ยังมีปัญหาอยู่ดี โดยเฉพาะอย่างยิ่ง หากไม่มีฐานข้อมูลของรูปต่างๆมากพอ มันก็อาจจะบรรยายออกมาได้ผิดสาระสำคัญเลยก็เป็นได้

อย่างเช่นรูปนี้ ที่ในภาพ เป็นคนกำลังเล่นฮ็อคกี้น้ำแข็งกันอยู่ แต่ระบบกลับตีความว่าผู้เล่นฮ็อคกี้ 2 คนนนี้กำลังต่อสู้กันในสนามแข่ง ซึ่งมันผิดสาระสำคัญไปมาก

ยังไงซะ ระบบนี้ก็ยังคงต้องการการปรับปรุงแก้ไขเพิ่มเติม รวมไปถึงการเก็บข้อมูลที่มากขึ้น เพื่อปรับทิศทางของการตีความคำบรรยาย ซึ่งหากระบบนี้ปรับปรุงแก้ไขได้ตามที่ตั้งเป้าไว้แล้วนั้น มันน่าจะสามารถบอกสิ่งที่อยู่ในรูปได้เป๊ะๆ โดยที่เราไม่ต้องทำการตรวจสอบซ้ำเลย ว่าสิ่งที่เห็นมันถูกต้องหรือไม่

ก็ มาคอยเอาใจช่วยว่านักวิจัยของทั้ง Google และ มหาวิทยาลัยสแตนฟอร์ดจะทำระบบออกมาให้พัฒนาต่อได้มากแค่ไหนนะครับ

ที่มา : The New York Times | EnGadget