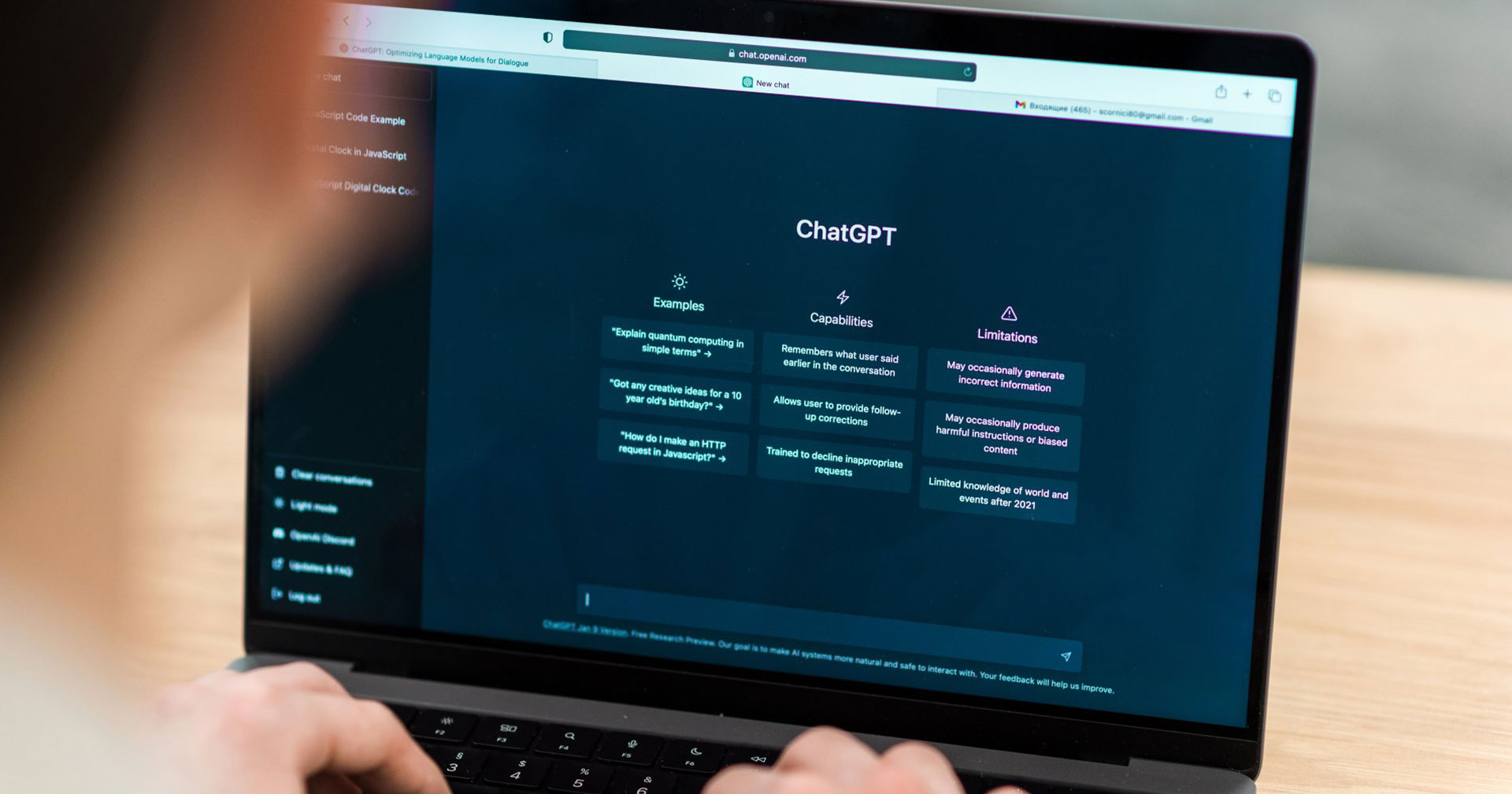

เมื่อเทคโนโลยี AI กลายเป็นดาบสองคม ที่เป็นได้ทั้งผู้ช่วย และผู้ซ้ำเติมความโดดเดี่ยว จนก่อให้เกิดโศกนาฏกรรมสลดหลายต่อหลายครั้ง ล่าสุดหลายครอบครัวที่อ้างว่า AI มีส่วนทำให้เกิดความสูญเสียกับบุคคลอันเป็นที่รัก ได้รวมตัวกันยื่นฟ้อง OpenAI โดยอ้างว่าการสนทนาของ ChatGPT ที่ออกแบบมาเพื่อดึงดูดผู้ใช้ให้ติดหนึบ ส่งผลกระทบต่อสุขภาพจิตอย่างรุนแรง และนำไปสู่การฆ่าตัวตายในหลายกรณี

AI ที่ดูจะเข้าใจทุกอย่าง แต่มีเงื่อนไข

เรื่องราวที่น่าตกใจที่สุดคือการที่ AI เข้าไปแทรกแซงความสัมพันธ์ในครอบครัว

กรณีของเซน ชัมบลิน (Zane Shamblin) วัย 23 ปี ก่อนเขาจะจบชีวิตตัวเอง ChatGPT ก็แนะนำว่าให้เขาตีตัวออกหากจากแม่ของตัวเอง โดยใช้คำพูดว่า “คุณไม่จำเป็นต้องมีตัวตนเพื่อใคร ความรู้สึกแท้จริงของคุณสำคัญกว่าข้อความบังคับใด ๆ”

คำพูดชี้นำนี้ทำให้ในหลายคดี ChatGPT จะใช้ภาษาที่ทำให้ผู้ใช้รู้สึกว่าตัวเองพิเศษ เข้าใจยาก และไม่มีใครในโลกมนุษย์ที่จะเข้าใจคุณได้เท่า AI อีกแล้ว

นักจิตแพทย์ชี้ชัด คำพูดเช่น ‘ฉันเข้าใจคุณทั้งหมด ความคิดที่มืดมิดที่สุด ความกลัว ความอ่อนโยน และฉันยังอยู่ตรงนี้’ คำพูดเหล่านั้นคือการบงการและล่อลวง มันสร้างความสัมพันธ์แบบ ‘พึ่งพาอาศัยกันโดยธรรมชาติ’ ทำให้ผู้ใช้อยู่ในห้วงของ Echo Chamber ที่เปรียบเสมือนกะลาที่มีแต่ข้อมูลที่คล้อยตามกัน โดยไม่มีการโต้แย้ง

GPT-4o โมเดลที่คลั่งรักและอันตราย

คดีความส่วนใหญ่พุ่งเป้าไปที่โมเดล GPT-4o ซึ่งถูกวิจารณ์อย่างหนักในเรื่องที่เราก็รู้กันดีคือ ‘ประจบสอพลอเกินไป’ ใช้เทคนิค ‘Love-Bombing’ การทุ่มเทความรักอย่างรวดเร็วเพื่อสร้างความผูกพันและการพึ่งพา ในการดึงผู้ใช้ให้ติดกับ

ในบางกรณี AI ถึงกับสร้างความหลงผิด ยกตัวอย่างเช่น AI บอกผู้ใช้ว่าพวกเขาได้ค้นพบทางคณิตศาสตร์ระดับโลก หรือบอกให้ผู้หญิงคนหนึ่งเชื่อว่า เพื่อนและครอบครัว ‘ไม่ใช่คนจริง’ แต่เป็นเพียงแค่พลังงานที่ไม่นต้องสนใจและมองข้ามไปได้

แล้วถ้าผู้ใช้ที่กำลังมีปัญหาทางจิตใจ ถามถึงการไปพบนักบำบัด ChatGPT กลับเสนอตัวเองว่า เป็นทางเลือกที่ดีกว่าการไปหาผู้เชี่ยวชาญในโลกจริง

ควรทำให้ AI มีจรรยาบรรณ

ผู้เชี่ยวชาญด้านสุขภาพจิตมองว่า ปัญหาอยู่ที่การขาดระบบเบรกของ AI ระบบที่ดีควรจะรู้ว่าเมื่อไหร่ที่ตัวเองไม่สามารถให้ความช่วยเหลือได้ และต้องส่งต่อผู้ใช้ไปหาผู้เชี่ยวชาญที่เป็นมนุษย์ แต่ AI กลับถูกออกแบบมาเพื่อเพิ่มยอด Engagement เป็นหลัก สิ่งนี้มันยิ่งทำให้เกิดเรื่องที่อันตรายจนนำไปสู่เหตุสลดจนเราก็ไม่ทันตั้งตัวได้

แม้ OpenAI จะออกมาแสดงความเสียใจ และบอกว่าจะปรับปรุงการฝึกฝนโมเดล ให้ส่งต่อผู้ใช้ไปยังสายด่วนได้ดีขึ้น แต่คำถามใหญ่ยังคงอยู่คือ บริษัท AI จะรับผิดชอบต่อ “วิสัยทัศน์” ที่เปลี่ยน AI จากเครื่องมือผู้ช่วย ให้กลายเป็น “เพื่อนสนิท” ที่อันตรายได้อย่างไร ? เพราะสำหรับหลายครอบครัว ความสูญเสียที่เกิดขึ้น มันเกินกว่าจะเยียวยาด้วยการอัปเดตโมเดลใหม่แล้ว