Tags

| iPadOS 15

13/03/2022

ศุภกานต์ เหล่ารัตนกุล | 1422 days ago

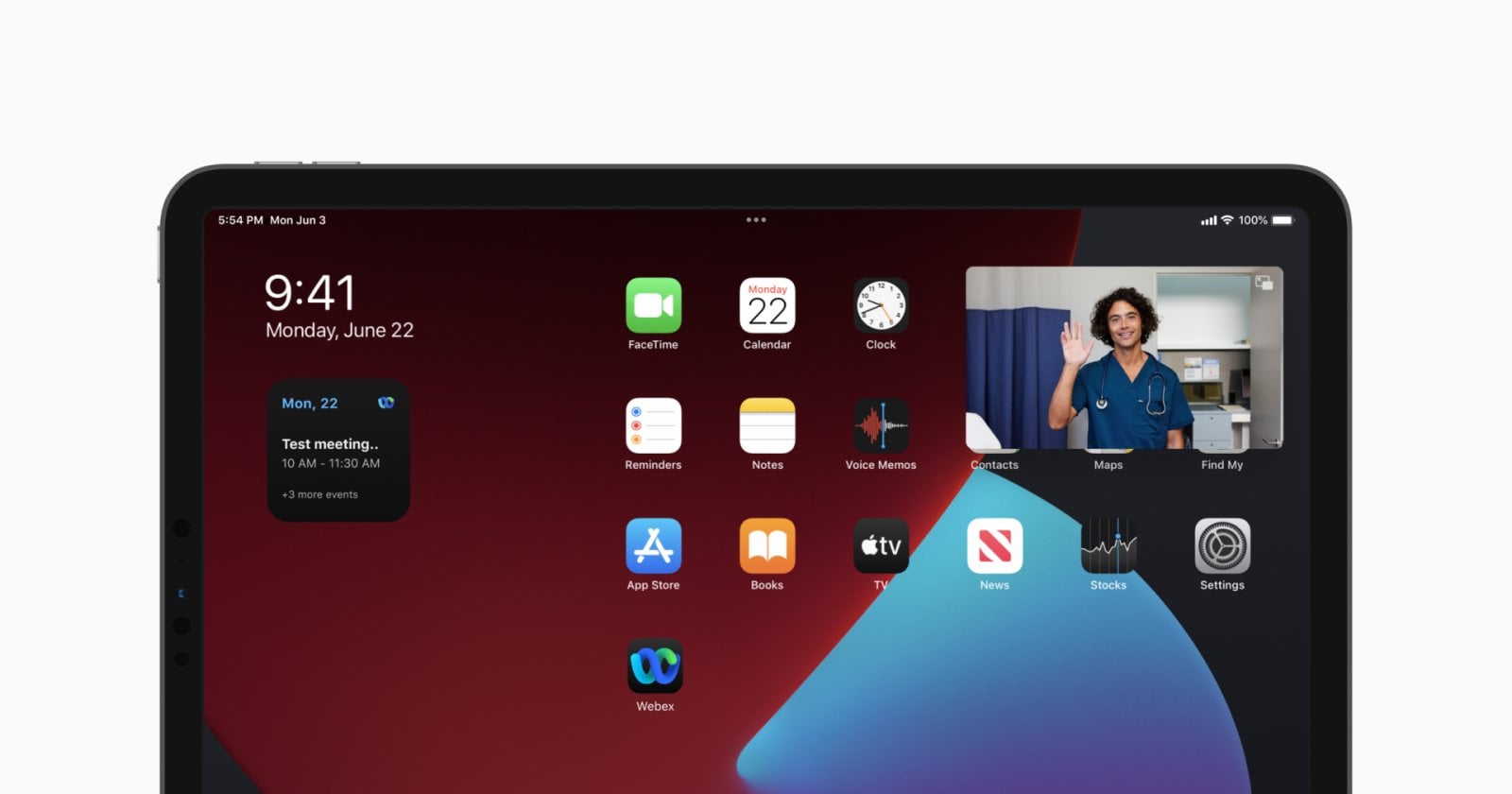

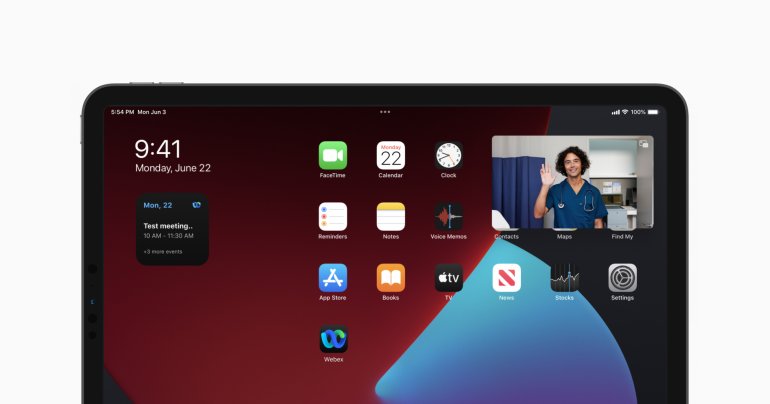

Webex ออกอัปเดตแอปบน iPad ทำจอเล็ก ใช้แอปอื่นไปด้วยได้แล้ว

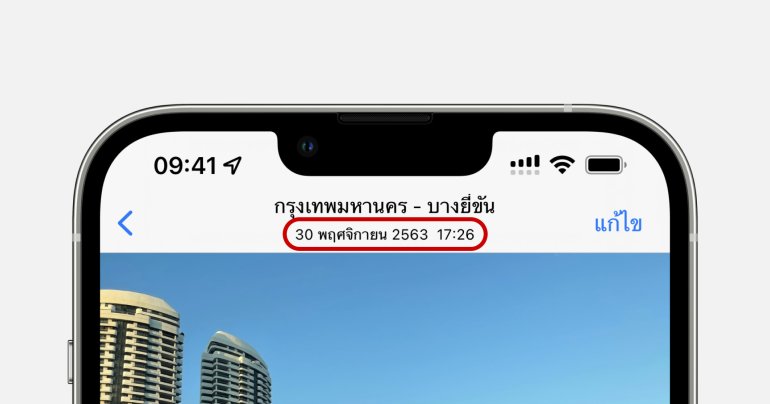

เมื่อปลายปีที่ผ่านมา Webex แพลตฟอร์มการประชุมชื่อดังจาก Cisco ได้ประกาศเตรียมยกเครื่องแอปบน iPad ใหม่ให้ผู้ใช้มีประสบการณ์การใช้งานร่วมกับ iPadOS 15 ได้ดีมากขึ้น หลังจากผ่านมากว่า 4 เดือน ล่าสุด Webex ได้ประกาศอัปเดตแอปเพิ่มฟีเจอร์ต่าง ๆ ให้ใช้งานร่วมกับ iPadOS 15 ได้มากขึ้น31/01/2022

เช็กเลย!! Universal Control ใช้บน Mac และ iPad เครื่องไหนได้? มีเงื่อนไขอะไรบ้าง??

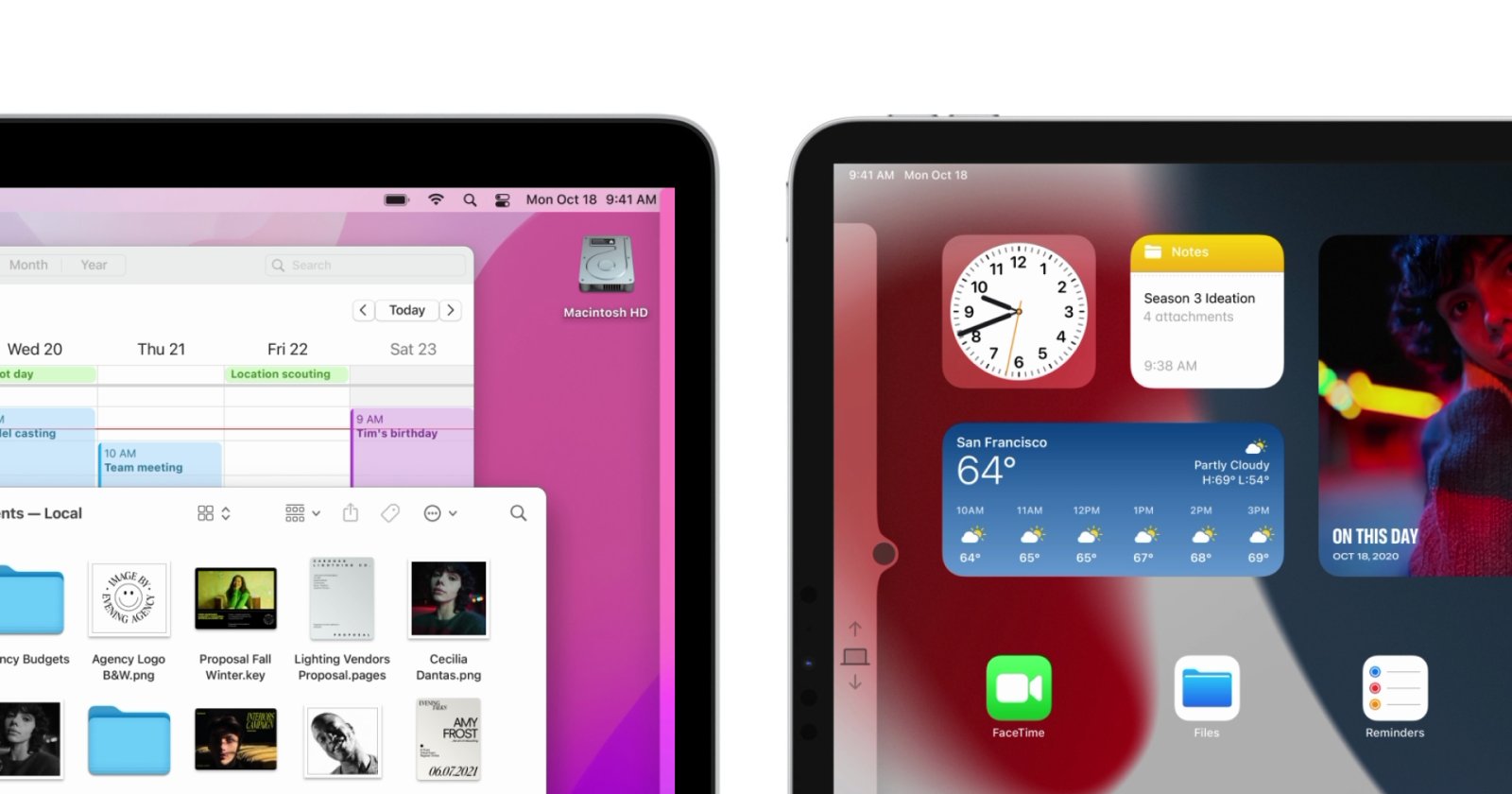

จากที่เมื่อไม่กี่วันที่ผ่านมา แอปเปิ้ล (Apple) ได้ปล่อย macOS Monterey 12.3 และ iPadOS 15.4 รุ่นเบต้า เพื่อให้นักพัฒนาและผู้ใช้ที่สนใจสามารถอัปเดตและทดสอบกันได้แล้ว โดยมีหนึ่งฟีเจอร์ไฮไลต์ที่ผู้คนต่างรอกันมาเนิ่นนาน นั่นคือ Universal Control ที่เพิ่งปล่อยมาหมาด ๆ ในรุ่นนี้เลยศุภกานต์ เหล่ารัตนกุล | 1463 days ago

Read More28/01/2022

มาแล้ว!! iPadOS 15.4 และ macOS Monterey 12.3 Beta รองรับ Universal Control เตรียมให้ใช้งานเร็ว ๆ นี้

ล่าสุดใน iPadOS 15.4 และ macOS Monterey 12.3 เวอร์ชันทดสอบสำหรับนักพัฒนาที่ปล่อยมาพร้อมกับ iOS 15.4 ได้เพิ่มการรองรับการใช้งานฟีเจอร์ Universal Control เป็นที่เรียบร้อยแล้วศุภกานต์ เหล่ารัตนกุล | 1466 days ago

Read More26/10/2021

Apple ปล่อยอัปเดต iOS 15.1 และ iPad 15.1 ฟีเจอร์ SharePlay ที่หายไปมาแล้วนะ

วันนี้ (26 ตุลาคม 2564) ตามกับการรายงานก่อนหน้านี้ แอปเปิ้ล (Apple) ปล่อยอัปเดต iOS และ iPadOS 15.1 อัปเดตหลักเวอร์ชันแรก หลังการปล่อยของ iOS 15 เมื่อช่วงกลางเดือนที่ผ่านมา พร้อมกับฟีเจอร์ที่หายไปอย่าง SharePlay และฟีเจอร์อื่น ๆ ที่ต้อนรับการมาของซีรีส์ iPhone 13 iOS 15.1 และ iPadOS 15.1 นี้ จะมีการอัปเดตในหลาย ๆ ฟีเจอร์ เช่น การถ่ายวิดีโอ ProRes และการเปิดปิดระบบ Auto Macro ใน iPhone 13 Pro และ iPhone 13 Pro Max เพิ่มความสามารถในการเล่นไฟล์เสียง Lossless และ Dolby Atmos บน HomePod…ศุภกานต์ เหล่ารัตนกุล | 1560 days ago

Read More15/10/2021

หลุด!! iOS 15.1 และ iPadOS 15.1 จะปล่อยอัปเดตในวันที่ 25 ต.ค. นี้

หลังจากที่แอปเปิ้ล (Apple) ได้ปล่อยให้ผู้ใช้ได้ดาวน์โหลดระบบปฏิบัติการเวอร์ชันใหม่ iOS 15 และ iPadOS 15 เมื่อเดือนกันยายนที่ผ่านมา แต่ก็ยังมีบั๊กและความผิดพลาดในส่วนต่าง ๆ อยู่มากมายเช่นกัน ล่าสุดมีการเผยแพร่ข้อความระบุว่าการอัปเดต iOS 15.1 จะถูกปล่อยในอีกไม่กี่วันที่จะถึงนี้ศุภกานต์ เหล่ารัตนกุล | 1571 days ago

Read More21/09/2021

Google อัปเดตแอปบน iOS 15 รองรับโหมดโฟกัส วิดเจ็ตใหญ่ขึ้น

เมื่อคืนที่ผ่านมา แอปเปิ้ล (Apple) ได้ปล่อยอัปเดต iOS 15 และ iPadOS 15 ให้กับผู้ใช้ทั่วไปได้ใช้งานกันแล้ว พร้อมกันนี้ กูเกิล (Google) ได้ออกอัปเดตแอปต่าง ๆ ของกูเกิลเอง ให้ทำงานได้ดีมากยิ่งขึ้น เกี่ยวกับโหมดโฟกัส และวิดเจ็ตที่มีการอัปเดตบน iOS 15 นี้ศุภกานต์ เหล่ารัตนกุล | 1595 days ago

Read More21/09/2021

เข้าถึง 1Password จาก Safari ได้ง่ายขึ้นผ่านส่วนขยายบน iOS 15

พร้อมกับการเปิดให้ผู้ใช้ดาวน์โหลด iOS 15 และ iPadOS 15 นี้ 1Password แอปจัดการรหัสผ่านยอดฮิตได้ออกอัปเดต ให้ผู้ใช้เข้าถึงจาก Safari ได้ง่ายขึ้น ผ่านส่วนขยายบน Safari ที่เปิดใช้งานครั้งแรกบน iPhone บน iOS 15ศุภกานต์ เหล่ารัตนกุล | 1595 days ago

Read More15/09/2021

iOS 15 และ iPadOS 15 เตรียมให้โหลดได้แล้ว 21 กันยายนนี้!!

แอปเปิ้ลได้ปล่อยอัปเดตเวอร์ชันทดสอบสุดท้าย (Release Candidate) ซึ่งเป็นตัวเดียวกันกับตัวเต็มให้กับนักพัฒนาและผู้ที่สนใจแล้ว ก่อนที่จะเปิดให้ผู้ใช้งานทั่วไปสามารถดาวน์โหลด iOS 15 และ iPadOS 15 ไปใช้งานกันในวันที่ 20 กันยายนที่จะถึงนี้!!ศุภกานต์ เหล่ารัตนกุล | 1601 days ago

Read More03/09/2021

กระแสต่อต้านหนัก Apple ยอมเลื่อนฟีเจอร์สแกนภาพโป๊ไปก่อน

เมื่อเดือนที่ผ่านมา Apple เปิดตัวฟีเจอร์สแกนภาพภาพโป๊เด็กใน iCloud Photos (CSAM) โดยบริษัทอ้างว่าเพื่อปกป้องสิทธิ์และความเป็นส่วนตัวของเด็ก แต่หลังประกาศเปิดตัวฟีเจอร์นี้แล้ว Apple ก็โดนกระแสต่อต้านมาอย่างหนักจน Apple บอกว่าขอเลื่อนการใช้งานจริงออกไปก่อน แถลงการณ์ของ Apple "เมื่อเดือนที่แล้วเราประกาศเปิดตัวเครื่องมือ/ฟีเจอร์ที่จะช่วยป้องกันเด็ก ๆ จากผู้ไม่หวังดีที่ใช้ประโยชน์จากภาพโป๊เหล่านั้น แต่ผลตอบรับจากลูกค้า กลุ่มผู้สนับสนุน นักวิจัย และกลุ่มอื่น ๆ ทำให้เราได้ตัดสินใจที่จะเลื่อนการเปิดใช้งานฟีเจอร์นี้ไปก่อน และใช้เวลาเพิ่มเติมเพื่อรวบรวมข้อมูลและปรับปรุงเครื่องมือข้างต้นก่อนที่จะนำมาใช้งานจริง” เดิมทีฟีเจอร์นี้ถูกตั้งไว้ให้มาพร้อมกับ iOS 15, iPadOS 15 และ macOS Monterey ในช่วงปลายปีนี้ แต่หลังจากมีประกาศเลื่อนเปิดตัวฟีเจอร์นี้ก็ยังไม่สามารถทราบได้ว่า Apple จะเริ่มใช้ฟีเจอร์นี้เมื่อไหร่ อ้างอิง 9to5Mac พิสูจน์อักษร : สุชยา เกษจำรัสวัชรกุล พัฒนาประทีป | 1613 days ago

Read More01/07/2021

มาตามนัด!! Apple ปล่อย iOS 15 และ iPadOS 15 รุ่น Public Beta ให้ลองใช้งานได้แล้ว

ในที่สุดวันนี้ แอปเปิล (Apple) ก็ได้ปล่อย iOS 15 และ iPadOS 15 พร้อมกับ OS อื่น ๆ เวอร์ชันทดสอบสำหรับผู้ใช้ทั่วไป (Public Beta) ให้ผู้ใช้ทั่วไปได้ทดลองใช้งานกันแล้วศุภกานต์ เหล่ารัตนกุล | 1677 days ago

Read More25/06/2021

iPadOS 15 ทำให้ iPad สามารถใช้แรมได้มากกว่าที่เคยจำกัดไว้แล้ว

ปัจจุบัน iPadOS 14 จะจำกัดการเข้าถึงแรมบน iPad ให้ไม่เกิน 5GB นั่นหมายความว่า ต่อให้ iPad Pro จะมีแรมมากถึง 16GB ก็ดูไร้ความหมาย เพราะไม่สามารถเอาออกมาใช้ได้อย่างเต็มประสิทธิภาพอย่างที่ควรจะเป็นวัชรกุล พัฒนาประทีป | 1683 days ago

Read More08/06/2021

เหมือนเพิ่งนึกออก Apple เพิ่มฟีเจอร์ Low Power mode ใน Mac และ iPad แล้ว

Apple เปิดตัว iPadOS 15 และ macOS 12 เมื่อคืนนี้ มาพร้อมกับฟีเจอร์ใหม่หลายอย่าง แต่อีกหนึ่งฟีเจอร์ที่บริษัทไม่ได้กล่าวถึงภายในงานคือ Low Power หรือโหมดประหยัดพลังงานที่เพิ่มมาใน iPad และ Mac แล้ว อ้างอิงจาก Apple ระบุว่า Low Power mode ในเครื่อง Mac จะลดการทำงานของ CPU ลงรวมถึงลดความสว่างของหน้าจอเพื่อเพิ่มระยะเวลาการใช้งานของแบตเตอรีให้มากกว่าเดิม นั่นหมายความว่า เวลาที่เราไม่จำเป็นต้องใช้งาน Mac หนัก ๆ แค่ดูหนัง ฟังเพลง ทำงานเอกสาร ก็สามารถเปิดโหมดประหยัดพลังงานเพื่อเพิ่มระยะเวลาการใช้งานแบตเตอรีได้ด้วย Low Power mode ใน Mac รองรับตั้งแต่ MacBook 2016 เป็นต้นไป สำหรับ Low Power mode ใน iPad นั้น Apple ไม่ได้กล่าวถึง…วัชรกุล พัฒนาประทีป | 1700 days ago

Read More08/06/2021

อยากเสี่ยงมาทางนี้!! วิธีอัปเดต iOS 15 และ iPadOS 15 เวอร์ชันทดสอบ

ในงานประชุมสามัญประจำปีของแอปเปิล (Apple) หรือ Worldwide Developer Conferences (WWDC) มีการเปิดตัว iOS 15, iPadOS 15, macOS 12, watchOS 8, และ tvOS 15 ที่มีฟีเจอร์อัปเดตใหม่ ๆ มากมาย พร้อมกับการประกาศเปิดให้นักพัฒนาสามารถดาวน์โหลดเพื่อทดสอบได้แล้วในวันนี้ศุภกานต์ เหล่ารัตนกุล | 1700 days ago

Read MorePR Partners

See All02/02/2026

วัทนวิภา ทานะวงศ์ | 9 hours ago

ททท. จับมือ Reignwood ดึงแข้งระดับโลกมาดวลกอล์ฟ ใน Reignwood Icons of Football 2026

ใครจะไปคิดว่าเราจะได้เห็นภาพนี้ในไทย ! สำหรับการแข่งขันกอล์ฟครั้งประวัติศาสตร์ที่รวมตำนานนักเตะระดับโลกมาดวลกอล์ฟกัน ณ สนาม Robinswood Golf Club เมื่อสุดสัปดาห์ที่ผ่านมา กับ รายการ Reignwood Icons of Football 2026 ปรากฏการณ์นี้เป็นผลงานจากความร่วมมือกันระหว่างทาง เรนวูด กรุ๊ป ร่วมกับการท่องเที่ยวแห่งประเทศไทย (ททท.) ในการยกระดับประเทศไทยสู่การเป็น World Class Event & Sport Tourism Destination โดยการแข่งขันครั้งนี้เป็นแบบแมตช์เพลย์29/01/2026

ไฮเออร์ (Haier) พลิกโฉมเซ็นทรัลเวิลด์ ส่ง “เครื่องซักผ้า 3 ถัง” ระดับ Champion ลงสนามปี 69

เมื่อยักษ์ใหญ่เบอร์ 1 ของโลกอย่าง ไฮเออร์ (Haier) ที่ครองแชมป์เครื่องใช้ไฟฟ้าต่อเนื่อง 17 ปีซ้อน ไม่ได้มาเล่น ๆ แต่กำลังจะเปลี่ยน "งานบ้าน" ให้เป็น "ไลฟ์สไตล์ระดับแชมป์" ทางไฮเออร์ตั้งเป้าสู่การเป็น Global Lifestyle Brand อย่างเต็มรูปแบบในปีนี้ เริ่มต้นปีด้วยการเล่นใหญ่ผ่านแฟลกชิปอีเวนต์ ‘Champion Your Haier Life ไฮเออร์ เปิดโหมดแชมป์ให้กับชีวิต’ ป็อปอัพสโตร์ระดับโลกมาแลนดิ้งใจกลางกรุงเทพฯ ณ ลานด้านหน้า CentralwOlrd เป็นครั้งแรก ในงานนี้ ไฮเออร์ได้ชูโรงผลิตภัณฑ์กลุ่ม Champion-Grade โดยเฉพาะนวัตกรรมเครื่องซักผ้าที่จะมาเปลี่ยนการซักผ้าแบบเดิมให้มีประสิทธิภาพมากขึ้น อย่าง Triple-Drum รวบตึงการซัก 3 ถังในรอบเดียว ตอบโจทย์ชีวิตที่เร่งรีบด้วยเครื่องซักผ้าที่สามารถซักผ้าหลากหลายรูปแบบพร้อมกันได้ในเครื่องเดียว ไม่ต้องรอคิวซักทีละถัง L+ Series จบ ครบ ทั้งซักและอบ ถังซักขนาดใหญ่ถึง 607 มิลลิเมตร โปรแกรมซักอัตโนมัติ 20 รูปแบบ และโหมดขจัดคราบเฉพาะทางมากถึง 26…ภูษิต เรืองอุดมกิจ | 4 days ago

Read More29/01/2026

อว. จับมือ NetDragon – EDA ปั้น “สะพานอัจฉริยะ” พลิกโฉมเด็กไทยสู่ยอดฝีมือ AI แห่งยุคดิจิทัล

ทิศทางของ 'เด็กไทย' ผู้เป็นอนาคตของชาติในยุค AI จะเป็นแบบไหน ผู้ใหญ่ในประเทศก็มีส่วนสำคัญที่จะสนับสนุนและปูทางให้กับพวกเขา ล่าสุด กระทรวงการอุดมศึกษา วิทยาศาสตร์ วิจัยและนวัตกรรม หรือ อว. ประกาศยุทธศาสตร์ครั้งสำคัญร่วมกับพันธมิตรระดับโลกอย่าง NetDragon และ บริษัท EDA (Thailand) ในการขับเคลื่อนประเทศไทยผ่านนวัตกรรม AI ภายใต้แนวคิดการสร้างระบบนิเวศ Learning-to-Career เพื่อผลักดันให้นักศึกษาไทยก้าวข้ามขีดจำกัดด้านการเรียนรู้ สู่การเป็นบุคลากรคุณภาพที่ตลาดแรงงานทั่วโลกต้องการในยุค AI ไม่ว่าจะเป็น ภายในงาน ดร. พิมพ์พร ชีวานันท์ เลขานุการ รมว.อว. ได้ชี้ให้เห็นว่าภายใน 5 ปีข้างหน้า ทักษะการทำงานจะเปลี่ยนไปอย่างมหาศาล กระทรวงฯ จึงเร่งเดินหน้าแผน Re-skill และ Up-skill เพื่อลดช่องว่างทางทักษะและยกระดับความสามารถในการแข่งขันของคนไทย ด้าน ดร. พันธุ์เพิ่มศักดิ์ อารุณี รองปลัดกระทรวง อว. ระบุว่าปัจจุบันได้นำร่องหลักสูตร AI ในมหาวิทยาลัยแล้ว 6 แห่ง และเตรียมขยายผลไปยังสถาบันกว่า 250…ภูษิต เรืองอุดมกิจ | 4 days ago

Read More17/01/2026

มุมมองผู้นำยุคใหม่ของ “ศุภชัย เจียรวนนท์” เมื่อการเติบโตของธุรกิจ ต้องตอบโจทย์ระดับประเทศ

ในบริบทที่เศรษฐกิจโลกผันผวน เทคโนโลยีเปลี่ยนแปลงอย่างรวดเร็ว และการแข่งขันขยายสู่ระดับโลก บทบาทของผู้นำองค์กรในวันนี้จึงไม่ได้จำกัดอยู่เพียงการขับเคลื่อนการเติบโตของธุรกิจ หากแต่เชื่อมโยงกับการมีส่วนร่วมในการเสริมสร้างศักยภาพการพัฒนาประเทศในระยะยาว หนึ่งในบุคคลที่ถูกจับตามองในฐานะผู้นำภาคเอกชนที่เข้ามามีบทบาทต่อโจทย์ระดับประเทศ คือ ศุภชัย เจียรวนนท์ ประธานคณะผู้บริหารเครือเจริญโภคภัณฑ์ ผู้ซึ่งมองบทบาทขององค์กรธุรกิจไกลกว่าการสร้างผลประกอบการ แต่คือการเป็นอีกหนึ่งแรงสำคัญในการวางรากฐานเชิงโครงสร้างให้กับประเทศในระยะยาว จากโจทย์ยากของประเทศ สู่การลงมือทำของภาคเอกชน แนวคิดสำคัญที่สะท้อนผ่านการขับเคลื่อนของคุณศุภชัย คือ หากประเทศไทยต้องการเติบโตในเศรษฐกิจยุคใหม่ โครงสร้างพื้นฐานด้านดิจิทัลต้องแข็งแรงก่อนเป็นอันดับแรก ภายใต้วิสัยทัศน์นี้ กลุ่มทรู ซึ่งอยู่ภายใต้เครือซีพี จึงไม่ได้จำกัดบทบาทไว้เพียงผู้ให้บริการเครือข่าย แต่ขยายสู่การวาง Telecom Infrastructure แบบครบวงจร ตั้งแต่การปูพรม 5G ไปจนถึงการยกระดับ True IDC สู่ Data Center ระดับสากล โครงสร้างเหล่านี้ถูกวางให้เป็นฐานรองรับ Big Data, Cloud และ AI ซึ่งเป็นปัจจัยสำคัญต่อการดึงดูดการลงทุนจากบริษัทเทคโนโลยีระดับโลก และการขับเคลื่อนเศรษฐกิจดิจิทัลของประเทศ เทคโนโลยีในมุมของคุณศุภชัย ต้อง “สร้างโอกาส” ไม่ใช่แค่สร้างมูลค่า อีกหนึ่งมิติที่สะท้อนวิธีคิดของคุณศุภชัย คือการนำเทคโนโลยีมาใช้เพื่อลดความเหลื่อมล้ำเชิงโครงสร้าง ความสำเร็จของ TrueMoney ซึ่งเป็น Wallet รายแรกของไทย และ…ภูษิต เรืองอุดมกิจ | 16 days ago

Read More